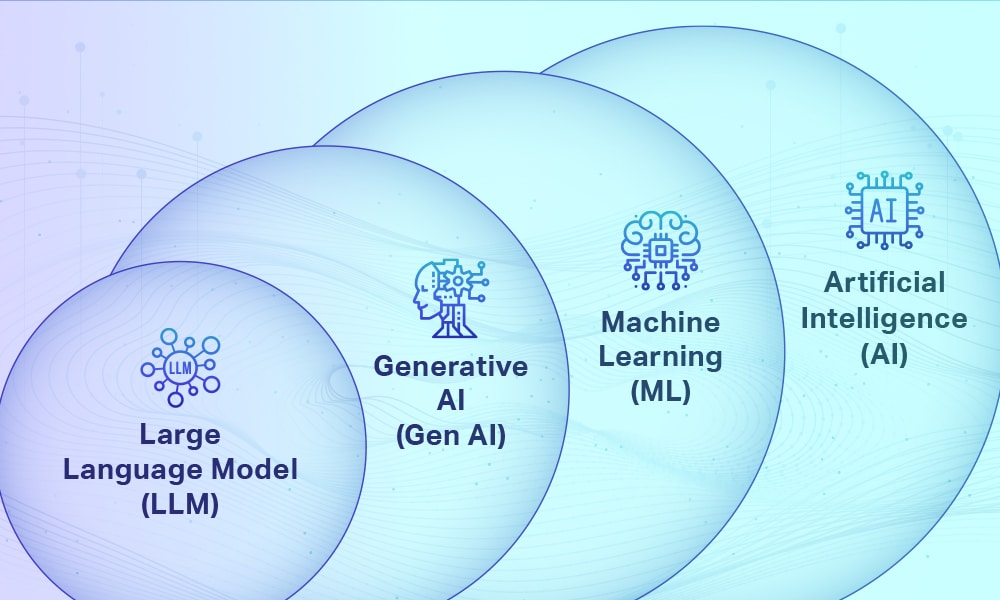

À l’ère de l’intelligence artificielle générative, les LLM occupent une place centrale, parfois au point de faire oublier qu’ils ne sont qu’une partie de l’IA.

Qu’est ce qu’une intelligence artificielle ?

L’intelligence artificielle est une notion forgée au milieu des années 1950, dans la foulée des réflexions du mathématicien Alan Turing, qui se demandait si un ordinateur saurait un jour « penser », ou s’il n’était capable que d’un « jeu d’imitation » (imitation game).

L’intelligence artificielle (IA) est un processus d’imitation de l’intelligence humaine qui repose sur la création et l’application d’algorithmes exécutés dans un environnement informatique dynamique. Son but est de permettre à des ordinateurs de penser et d’agir comme des êtres humains.

Pour y parvenir, trois composants sont nécessaires :

- Des données avec des systèmes de gestion

- Des algorithmes d’IA avancés (code)

- Des systèmes informatiques

Pour se rapprocher le plus possible du comportement humain, l’intelligence artificielle a besoin d’une quantité de données et d’une capacité de traitement élevées.

Les champs d’action de l’IA sont vastes et semblent difficiles à circonscrire puisqu’ils s’étendent à de nombreux aspects du quotidien que ce soit pour effectuer des recherches ou des achats en ligne, le ciblage publicitaire, la traduction automatique, les assistants numériques personnels, les villes connectées, mais aussi dans le domaine des transports, de la santé, etc.

Qu’est ce qu’une LLM ?

Un grand modèle de langage (Large Language Model, LLM) est un type de programme d’intelligence artificielle (IA) capable, entre autres tâches, de reconnaître et de générer du texte. Les LLM sont entraînés sur d’immenses ensembles de données, d’où l’emploi du terme « large » (grand) dans la dénomination anglaise. Ils s’appuient sur l’apprentissage automatique (Machine Learning, ML), et plus spécifiquement sur un type de réseau neuronal appelé « modèle transformeur ».

En termes plus simples, un LLM est un programme informatique qui a assimilé suffisamment d’exemples pour être capable de reconnaître et d’interpréter le langage humain ou d’autres types de données complexes.

Les LLM peuvent être entraînés pour effectuer un certain nombre de tâches. L’une des utilisations les plus connues est leur application en tant qu’IA générative : ils sont capables de produire un texte en réponse à un prompt (ou invite) ou une question. ChatGPT, un LLM accessible au public, peut par exemple générer des essais, des poèmes et d’autres formes de texte en réponse à la saisie de l’utilisateur.

IA vs LLM : la différence en un coup d’œil

La principale différence entre l’IA et les LLM réside dans leur objectif et leur domaine d’application. L’IA est un domaine d’étude plus vaste qui englobe différentes techniques et tâches, tandis que les LLM sont des modèles spécifiques utilisés dans le cadre de l’IA pour le traitement du langage naturel.

Par exemple, « l’IA générative est le moulin à paroles des soirées cocktail qui alimentait la conversation avec des anecdotes extravagantes, tandis que les LLM sont des bibliothécaires méticuleux qui cataloguaient tous les mots prononcés lors de chaque fête ».

Les outils d’IA générative textuelle, tels que ChatGPT, sont indissociables des modèles de langage de grande taille (LLM). Les LLM ont connu une croissance exponentielle au cours des dernières années et alimentent l’IA générative en lui fournissant les données dont elle a besoin. En effet, nous n’aurions rien de comparable à ChatGPT sans les données et les modèles permettant de les traiter.

Pourquoi cette distinction est importante

Confondre intelligence artificielle et modèles de langage peut sembler anodin, mais cette approximation entraîne des malentendus importants. En assimilant toute l’IA aux LLM, on surestime parfois leurs capacités tout en sous-estimant la diversité des technologies existantes.

Pour les entreprises, cette distinction est cruciale : un LLM n’est pas toujours la solution la plus adaptée à un besoin métier. Certains cas d’usage relèvent davantage de l’analyse de données, de la vision par ordinateur ou de l’optimisation algorithmique. Choisir la mauvaise technologie peut conduire à des projets coûteux et inefficaces.

Pour les décideurs et le grand public, comprendre cette différence permet aussi de mieux appréhender les enjeux éthiques, réglementaires et sociétaux liés à l’IA. Réguler l’IA ne signifie pas uniquement encadrer les outils conversationnels, mais bien l’ensemble des systèmes automatisés capables d’influencer nos décisions et nos comportements.

Vers des IA hybrides : la suite logique

L’avenir de l’intelligence artificielle ne repose pas sur les LLM seuls, mais sur leur intégration avec d’autres formes d’IA. On voit déjà émerger des systèmes hybrides combinant compréhension du langage, vision, raisonnement et capacité d’action.

Dans ces architectures, les LLM jouent souvent le rôle d’interface intelligente : ils interprètent des instructions humaines, orchestrent des outils spécialisés et traduisent des résultats complexes en langage naturel. Associés à des systèmes de calcul, de perception ou de planification, ils deviennent des briques essentielles de ce que l’on appelle des agents autonomes.

Cette convergence ouvre la voie à des applications plus robustes, plus fiables et mieux alignées sur des besoins concrets, tout en dépassant les limites actuelles des modèles purement textuels.

Mieux nommer pour mieux comprendre

Les modèles de langage de grande taille ont profondément transformé notre rapport à l’intelligence artificielle, en la rendant plus visible, plus accessible et plus intuitive. Pourtant, ils ne représentent qu’une facette d’un écosystème bien plus vaste.

Comprendre la différence entre IA et LLM, c’est se donner les moyens d’avoir un regard plus lucide sur ces technologies : reconnaître leur puissance sans les mythifier, identifier leurs limites sans les minimiser. À l’heure où l’IA s’invite dans tous les secteurs, cette clarification n’est pas un détail technique, mais une condition essentielle pour en faire un usage éclairé et responsable.